搭建一个本地的deepseek环境

背景

最近deepseek很火,性能最好的肯定是网页版本或者官方的api的版本,但是目前的服务可用性还存在一点问题,如果对数据的隐私有一定的要求可以部署本地的版本,这个操作很简单

部署方法

下载ollama

https://ollama.com/

下载对应的版本即可,我的是mac mini m4,24G内存,这个配置跑起来还是很流畅的

这个工具类似一个容器,会把模型加载起来,下载好了后,去下载对应模型即可

下载模型

1 | |

在iterm的终端运行这两条命令会自动下载这两个模型,如果命令行使用,直接执行上面的命令即可,如果需要有图形界面使用,还要下个工具

下载chatbox

下载以后就可以本地运行图形界面直接使用了

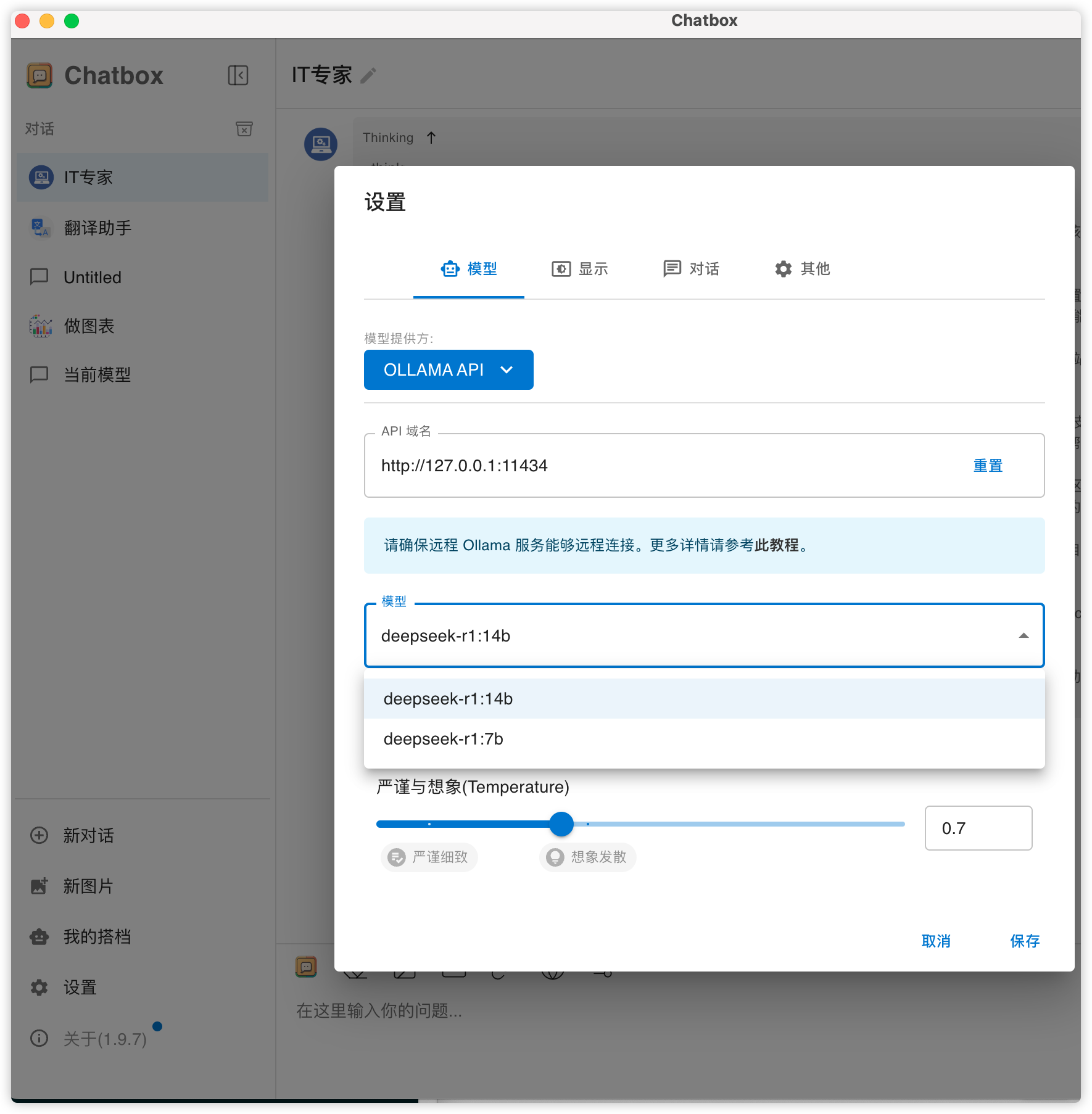

配置模型提供方选择ollama api

模型选择下载好的模型即可

7b的模型输出速度快很多

14b的模型稍微慢点,但是也是很快的,用起来体验感也可以

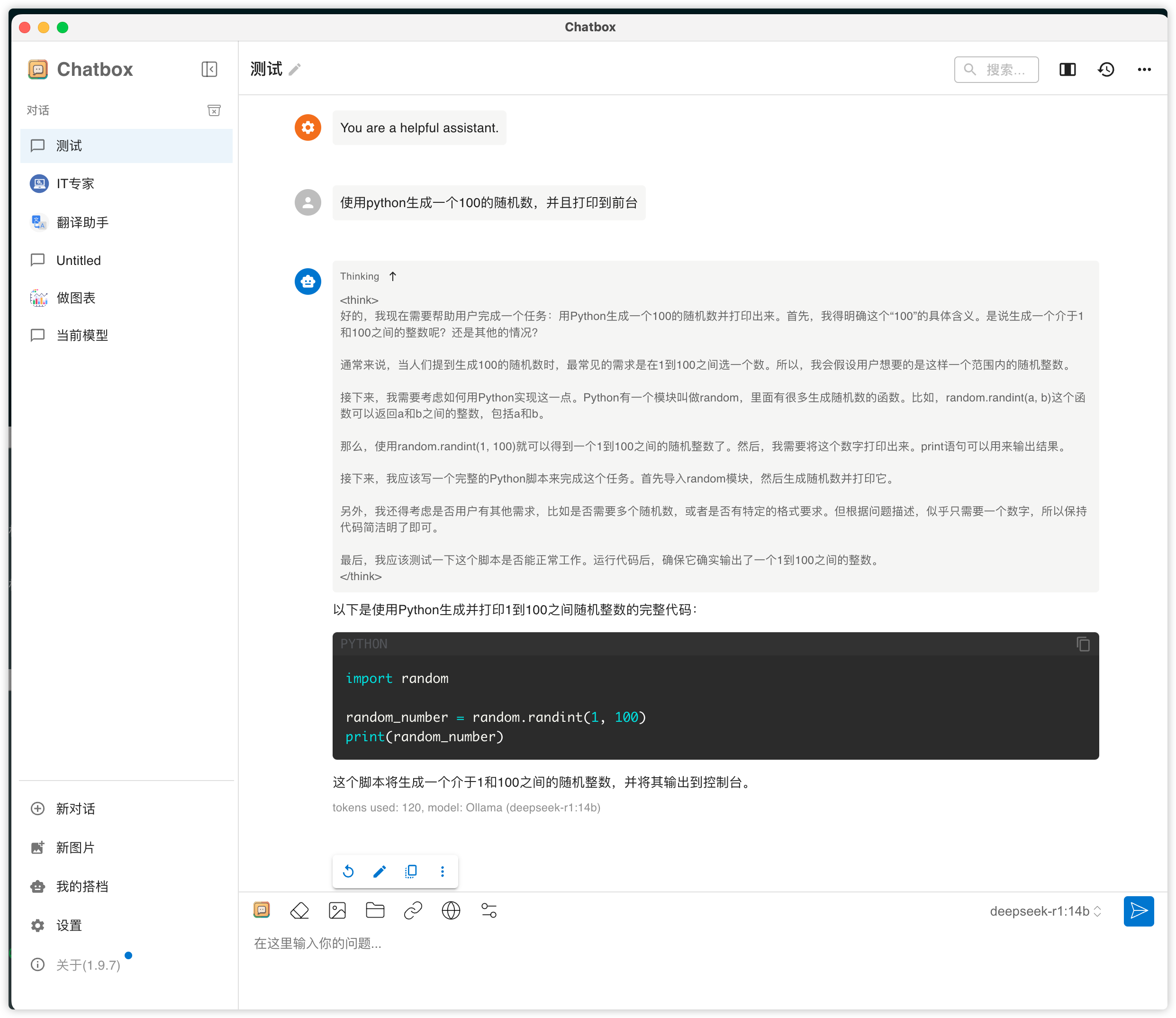

使用效果

里面的有个推理的过程还是很好的

总结

- 能用网页版本可以用网页版本,网页版本还支持联网

- 如果对本地的数据隐私有要求的,可以部署本地版本,大部分场景还是可以覆盖的

搭建一个本地的deepseek环境

https://zphj1987.com/2025/02/08/搭建一个本地的deepseek环境/